Kémek, katonák, nyelvészek: a lehallgatástól a gépi fordításig

Ma már természetes, hogy működik a kereső, hogy lefordítjuk a Google találatait, vagy hogy feliratozott videókat nézünk meg. Pedig ezekhez bonyolult dekódolási folyamatok, a számítógépes nyelvészet vívmányai szükségesek. Hogy honnan indult mindez? Hát a hadászatból.

A számítógépes nyelvészet egy olyan, viszonylag friss, ámde erőteljesen fejlődő és terjeszkedő szakterület, amelynek célja az emberi nyelvhasználat, -elsajátítás és -megértés gépi modellálása. Ez is, mint oly sok minden, a 2. világháború hadi fejlesztéseinek köszönheti létét. A háború alatt rendkívüli stratégiai jelentőséggel bírt az ellenség üzeneteinek dekódolása, amire többféle módszert is alkalmaztak – az egyik városi legenda szerint az amerikaiak valamelyik indián nyelven közvetítették az információt, a németek pedig vért izzadva sem tudták megfejteni, mivel azt gondolták, hogy ez egy mesterséges kód. Vagyis az amerikaiak azt a kézenfekvő, de meglepő ötletet alkalmazták, hogy egy természetes nyelvet használtak közvetítőként két másik természetes nyelv között.

Gépekkel is lehet fordítani?

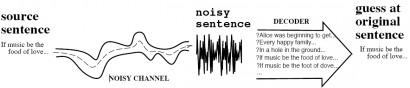

Bizonyára azért okozott a német kriptográfusok számára ez olyan nagy nehézséget, mert a számítógépek és kódok vonatkozásában eszükbe sem jutott a természetes nyelvek használata. Valószínű, hogy a háború kódfejtő próbálkozásai adtak ihletet Warren Weavernek ahhoz az ideájához, amit 1949-ben publikált, és ami szerint az egyik nyelvről a másikra való fordítás gépekkel is megvalósítható lehet. A számítógépes nyelvészet születéséhez kötött másik nagyhatású tanulmány, és ami egyébként egy kötetben jelent meg Weaverével, Claude E. Shannon írása a kommunikációról mint általános hírközlési rendszerről. Ebben fejti ki azt a metaforát, ami szerint a természetesnyelv-feldolgozási problémák megfeleltethetők dekódolási

problémáknak egy zajos kommunikációs csatornában.

Az első időkben tehát a háborús kriptográfiából kinőtt gépi fordítási kísérletek uralták a számítógépes nyelvfeldolgozás területét. A kezdeti lelkesedést az ALPAC (Automatic Language Processing Advisory Committee) 1966-os jelentése törte le, amiben arról számoltak be, hogy a gépi fordítás mégsem olyan egyszerű dolog, mint azt gondolták. Úgy látták, ehelyett a messzire kitűzött túl nagy cél helyett a forrásokat inkább a számítógépes nyelvészeti alapkutatásokra kellene allokálni. Ennek a tanulmánynak a megjelenését a számítógépes nyelvészet fekete napjaként szokták számon tartani, mert – ahogy ez felsővezetői szinten lenni szokott – a pénzt nemcsak a gépi fordítás további fejlesztésétől, hanem az összes természetesnyelv-feldolgozási projekttől elvonták.

A gépi fordítás témája legközelebb a 80-as években került ismét elő, immár a civil szféra közelében: célja az egymás nyelvét nem beszélő emberek közötti kommunikációs gát ledöntése, valamint a különböző nyelveken íródott nagy mennyiségű, elsősorban hivatalos iratok gyorsabb fordítása volt. De természetesen a gépi fordítás és dekódolás hadiipari-nemzetbiztonsági felhasználása sem tűnt el: gondoljunk csak arra, hogy az amerikai elhárítás állandóan figyeli az arab nyelvű tévéadásokat, e-maileket, üzeneteket.

Tű a szénakazalban – miről levelezhet Abdul és Iszmaila?

Az amerikai elhárítás összes munkaereje sem lenne elég, ha minden kommunikációs csatorna minden arab nyelvű üzenetét emberi erővel akarnák dekódolni és feldolgozni. (Arról nem is beszélve, hogy arabul és angolul is magas szinten tudó, az USA mellett elkötelezett szakemberekből viszonylag kevés lehet.) Vagyis a terrorista-elhárításnak és a nemzetvédelemnek világszerte szüksége van olyan félig vagy teljesen automatikus eszközökre, amelyek a célszövegek megértését, feldolgozását segítik, de legalábbis kiszűrik a töménytelen mennyiségű információ közül a relevánsakat. Azt még az amerikai titkosszolgálatról sem gondoljuk, hogy iszonyúan érdeklődne Abdul és Iszmaila szerelmetes levelezése iránt – már amennyiben Abdul és Iszmaila nem öngyilkos merénylők.

Keressünk bombát!

Milyen számítógépes nyelvészeti eszközökre lehet szüksége a titkosszolgálatnak? Elsősorban olyanra, amely a rengeteg szövegből kiszűri azokat a részleteket, amelyek nemzetbiztonságilag kockázatos dolgokra utalnak. Vegyünk egy egyszerű esetet: feltételezzük, hogy az összes önjelölt terrorista teljesen tökkelütött, és simán levelezget a bombák elkészítéséről. Ilyenkor csak az a dolgunk, hogy megtaláljuk az összes olyan szöveghelyet, ahol a bomba szót használják. Ha írott szövegben keresünk, először is a szöveget fel kell bontanunk szavakra és mondatokra. Akkor innentől már csak az a feladat, hogy a szavakra egyenként illesztjük a keresendő szót, és kiiratjuk azokat a mondatokat, amikben megtaláltuk – gondolhatnánk, de persze közel sem ilyen egyszerű a dolog. Mert ugye mi van, ha a célnyelv olyan különlegesen nagyon ragozó, mint édes anyanyelvünk, akkor a bomba szótári tő illesztésével vajmi kevés találatot fogunk kapni. Vagy mi van, ha nem csak simán bombáról levelezgetnek találékony terroristáink, hanem csőbombáról? Egy sima illesztéssel ez is kimaradna. Ezért szükség van egy morfológiai elemzőre is, ami a szöveg minden egyes szaváról megállapítja legalább a szófaját és a tövét. Feladatunk azonban még itt sem ért véget, mivel a számítógépes morfológiai elemzőnek van egy olyan hülye tulajdonsága, hogy egy adott szó minden lehetséges felbontását és elemzését elvégzi – ebből születhetnek ilyen vicces eredmények is:

> falucska

fa/NOUN+lucsok/NOUN<POSS>

falucska/NOUN

falu/NOUN[DIMIN]/NOUN

> kerekesszék

kerek/NOUN+esszé/NOUN<PLUR>

kerek/ADJ+esszé/NOUN<PLUR>

kerekes/ADJ+szék/NOUN

kerék/NOUN[ATTRIB]/ADJ+szék/NOUN

kerek/NOUN[ATTRIB]/ADJ+szék/NOUN

kerek/ADJ[ATTRIB]/ADJ+szék/NOUN

Az a jellemző, hogy a morfológiai elemző egy szóalakra több elemzést is kiad, vagyis döntenünk kell a lehetséges kimenetek között. Természetesen ezt sem kell kézzel végezni, léteznek 95% fölötti pontossággal dolgozó egyértelműsítők, melyek a szó környezete alapján megállapítják az egyetlen helyes elemzést.

A nevek és a nemzetbiztonság

De vannak olyan elemek is a mondatban, amelyekkel a morfológiai elemző és egyértelműsítő sem tud rendesen elbánni, viszont rendkívül fontosak lehetnek nemzetbiztonsági szempontból is: ezek a tulajdonnevek és az olyan többszavas kifejezések, amelyeket egy egységként kell kezelnünk, különben elveszítik értelmüket. Ezzel a feladattal foglalkozik a számítógépes nyelvészeten belül a tulajdonnév-felismerés (Named Entity Recognition, NER), ami nélkülözhetetlen lépése bármilyen szöveg nyelvi elemzésének, az eseménykivonatolásnak vagy a gépi fordításnak.

Az, hogy a gépi fordító rendszer bizonyos szavakat vagy szósorokat nem tud névként azonosítani, sok fordítási hibának a forrása. Természetesen ez a szakterület is hadiipari céllal jött létre eredetileg. A tulajdonnév-felismerés témája hivatalosan 1995-ben, a hatodik Message Understanding Conference (MUC) kiírásában bukkant fel először. Ezeknek a konferenciáknak az volt a célja, hogy a jelentkezőket versenyeztessék abban, mennyire eredményes az általuk fejlesztett információkinyerő rendszer. A versenyzőknek mindig előre meghatározott témájú szövegeken kellett dolgozniuk, a hetedik MUC-on például légi járművek leírásain. A MUC-ok és egyéb hasonló fejlesztések támogatója a Defense Advanced Research Projects Agency (DARPA), az amerikai elhárítás kutató-fejlesztő részlege volt, ami azóta is minden nagyobb számítógépes nyelvészeti fejlesztésben megjelenik valamilyen formában.

Hadászattól hétköznapig

A dekódolandó és feldolgozandó üzenetek egy jó része nem írott, szöveges formában található, hanem szóban hangzik el. A hangzó üzenetek dekódolásával, a beszélő azonosításával, az elhangzott anyag átírásával, illetve a beszéd mesterséges előállításával foglalkozik a beszédtechnológia. A nemzetbiztonság szempontjából fontosak lehetnek például azok az alkalmazások, amelyek lehetővé teszik a lehallgatott telefonbeszélgetések automatikus lejegyzését (a bevett angol kifejezéssel élve: speech-to-text), vagy azonosítják a beszélőt. Hangunk olyan, mint az ujjlenyomat: egyedi jellegzetességei alapján egyértelműen azonosítható a beszélő. Vagy gondoljunk az olyan kütyükre, amelyeket az amerikai filmekben látunk: a nyomozó kérdez valamit a latin szemtanútól, az orra alá dugja a kütyüt, amibe a szemtanú belehablatyol valamit spanyolul, majd a szerkezet kiírja angolul a „megfejtést”. Ehhez először is arra van szükség, hogy a gép azonosítsa, milyen nyelven kapja az anyagot, majd egy beszédfelismerő alkalmazás segítségével feldolgozza a hallottakat, amit azután átírhat szöveggé. Innentől már csak egy lépés a spanyol-angol gépi fordítás, és a célnyelvi mondat kiírása. Vagyis a beszélt nyelvi anyagok feldolgozását még egy átírási lépés is megnehezíti.

Ahogy más szakterületeken, a számítógépes nyelvészet területén is megfigyelhetjük a fejlesztések eltolódását a hadiipartól a civil szféra felé. A kezdetben hadászati célokra használt alkalmazásokat ma már rutinszerűen használjuk a mindennapi életben. Amikor elindítunk egy keresést a Google-on, számítógépes nyelvészeti fejlesztések hadát mozgósítjuk a háttérben azért, hogy megkapjuk a legrelevánsabb találatokat; amikor ráklikkelünk a Translate gombra, számítógépek százai bőgnek föl, hogy dekódolják az üzenetünket; vagy amikor videókat nézegetünk a YouTube-on, a beszédtechnológia vívmányainak köszönhetően feliratozva is olvashatjuk a szöveget.

Hmm.

Nagyon érdekes téma.

Jó sok információ van benne, főleg Amerikaiakról, de hát kérem szépen.

A dekódolási probléma is teljesen érthető, meg gondolom egy nyelvésznek, meg egy programozónak is adódhatnak problémái az egymást megértésben, hiszen egy nyelvész nem feltétlenül tud programozni, és vice verza. Ez még érdekelne engem.

Köszi a cikkért,

H.